|

||

|

|

||

|

|

Онлайн книга - Идиот или гений? Как работает и на что способен искусственный интеллект | Автор книги - Мелани Митчелл

Cтраница 42

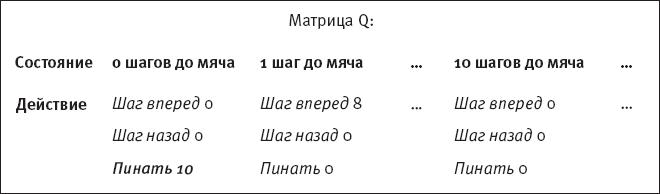

Рис. 24. Матрица Q для Рози после первого эпизода обучения с подкреплением Рози запоминает ценность действий в большой таблице, которая хранится в ее компьютерной памяти. В этой таблице, показанной на рис. 24, перечисляются все возможные состояния Рози (то есть все возможные расстояния до мяча в пределах поля) и возможные действия для каждого состояния. Каждое действие в конкретном состоянии имеет числовую ценность, и значения ценности меняются по мере обучения Рози, все точнее прогнозируя будущие вознаграждения. Таблица состояний, действий и ценностей называется матрицей Q. Такая форма обучения с подкреплением иногда называется Q-обучением. Буква Q используется, потому что в первой статье о Q-обучении буквой V (от value, “ценность”) было обозначено кое-что другое [180].

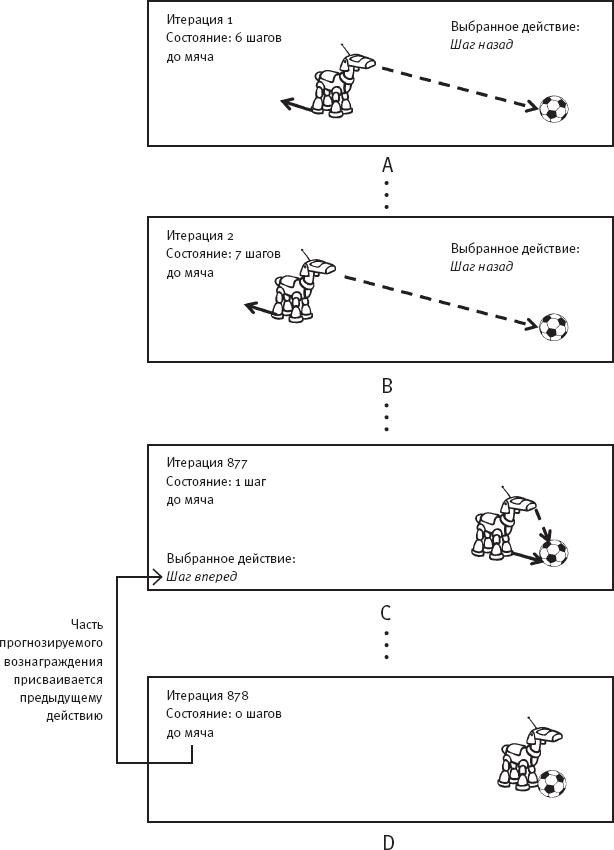

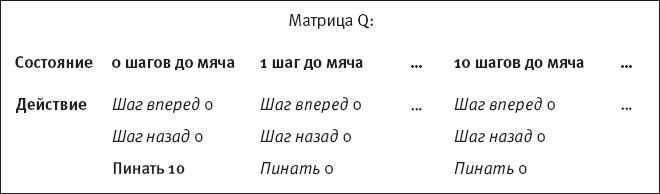

Рис. 25. Второй эпизод обучения с подкреплением В начале обучения Рози я составляю исходную матрицу Q, присваивая всем ценностям значение 0 – нулевое значение. Когда Рози получает сигнал подкрепления, пнув мяч в конце эпизода 1, действию Пинать в состоянии “0 шагов до мяча” присваивается значение ценности 10, то есть величина вознаграждения. В будущем, оказавшись в состоянии “0 шагов до мяча”, Рози сможет посмотреть в матрицу Q, увидеть, что действие Пинать имеет самую высокую ценность – то есть является индикатором самого высокого уровня вознаграждения, – и выбрать Пинать, вместо того чтобы выбирать действие наугад. Вот что значит здесь “обучение”! Эпизод 1 закончился на том, что Рози наконец пнула мяч. Теперь мы переходим к эпизоду 2 (рис. 25), в начале которого мяч и Рози оказываются на новых позициях (рис. 25 А). Как и раньше, на каждой итерации Рози определяет свое текущее состояние – изначально она находится в шести шагах от мяча – и выбирает действие, теперь уже сверяясь со своей матрицей Q. Однако на этом этапе все возможные действия в текущем состоянии по-прежнему имеют нулевую ценность, а следовательно, у Рози пока нет информации, которая помогла бы ей сделать выбор. В связи с этим Рози снова выбирает действие случайным образом и делает Шаг назад. Она также делает Шаг назад на следующей итерации (рис. 25 B). Нашей собаке-роботу еще учиться и учиться. Все продолжается как раньше, пока, следуя долгим путем проб и ошибок, Рози не оказывается в одном шаге от мяча (рис. 25 C) и случайным образом не выбирает Шаг вперед. Вдруг нога Рози касается мяча (рис. 25 D), и матрице Q есть что сказать об этом состоянии. В частности, она говорит, что в текущем состоянии – в нуле шагов от мяча – есть действие Пинать, которое вызовет вознаграждение 10. Теперь Рози может использовать эту информацию, усвоенную в предыдущем эпизоде, чтобы выбрать действие, а именно – Пинать. Но вот в чем суть Q-обучения: теперь Рози может узнать кое-что о действии (Шаг вперед), которое она выполнила в предыдущем состоянии (в одном шаге от мяча). Именно это действие привело ее на прекрасную позицию, которую она заняла сейчас! В частности, действию Шаг вперед в состоянии “один шаг до мяча” присваивается более высокая ценность в матрице Q, и эта ценность составляет некоторую долю ценности действия Пинать в состоянии “ноль шагов до мяча”, которое непосредственно ведет к получению сигнала подкрепления. Здесь я присвоила этому действию ценность 8 (рис. 26).

Рис. 26. Матрица Q для Рози после второго эпизода обучения с подкреплением Теперь матрица Q говорит Рози, что ей очень полезно выбирать Пинок в состоянии “0 шагов до мяча” и почти настолько же полезно делать Шаг вперед в состоянии “1 шаг до мяча”. Когда Рози в следующий раз окажется в состоянии “1 шаг до мяча”, у нее будет информация о том, какое действие предпринять, а также возможность обновить ценность действия, непосредственно предваряющего это состояние, то есть действия Шаг вперед в состоянии “два шага до мяча”. Обратите внимание, что ценности действий должны снижаться (в результате “уценки”) по мере удаления от вознаграждения, поскольку это позволяет системе узнать эффективный путь к нему. Обучение с подкреплением – то есть постепенное обновление ценностей в матрице Q – продолжается эпизод за эпизодом, пока Рози не научится выполнять задачу с любой начальной точки. Алгоритм Q-обучения – это способ присваивать ценности действиям в конкретном состоянии, включая действия, которые непосредственно не ведут к получению вознаграждения, но подготавливают почву для относительно редких состояний, в которых агент его получает. Я написала программу, моделирующую процесс Q-обучения Рози, описанный выше. В начале каждого эпизода Рози помещалась лицом к мячу в случайном количестве шагов от него (при максимуме в двадцать пять и минимуме в ноль шагов от мяча). Как я упоминала ранее, если Рози оказывалась за пределами поля, моя программа просто возвращала ее назад. Каждый эпизод заканчивался, когда Рози добиралась до мяча и пинала его. Чтобы научиться выполнять задачу идеально, какой бы ни была ее исходная позиция, Рози понадобилось около трехсот эпизодов. На примере “обучения Рози” я показала суть обучения с подкреплением, но опустила при этом множество проблем, с которыми исследователи сталкиваются при выполнении более сложных задач [181]. Так, в реальном мире агент часто не может сказать наверняка, в каком состоянии находится, в то время как Рози точно знает количество шагов до мяча. Настоящий робот-футболист может лишь примерно оценивать расстояние и даже сомневаться насчет того, какой именно небольшой светлый объект на поле является мячом. Эффекты выполнения действия тоже порой неоднозначны: так, делая Шаг вперед, робот может преодолевать различные расстояния в зависимости от ландшафта, а также может падать или сталкиваться с незамеченными препятствиями. Как обучению с подкреплением справляться с такой неопределенностью? И как обучающемуся агенту выбирать действие на каждом этапе? Примитивная стратегия требовала бы всегда выбирать действие, которое имеет самую высокую ценность в матрице Q для текущего состояния. Но в этой стратегии есть проблема: вполне возможно, что другие, еще не проверенные действия приведут к получению большего вознаграждения. Как часто агенту следует зондировать почву, выбирая действия, которые он еще не выполнял, и как часто следует делать то, за что он уже ожидает получить вознаграждение? Когда вы идете в ресторан, вы всегда заказываете блюдо, которое уже пробовали и сочли вкусным, или делаете другой выбор, потому что в меню могут быть более интересные варианты? Решение, в какой степени исследовать новые действия, а в какой – использовать проверенные, называется балансом исследования-использования. Достижение верного баланса – ключ к успеху обучения с подкреплением.

|

Вернуться к просмотру книги

Вернуться к просмотру книги

Перейти к Оглавлению

Перейти к Оглавлению

Перейти к Примечанию

Перейти к Примечанию

© 2020 pharmateka.ru - электронная библиотека в которой можно

© 2020 pharmateka.ru - электронная библиотека в которой можно